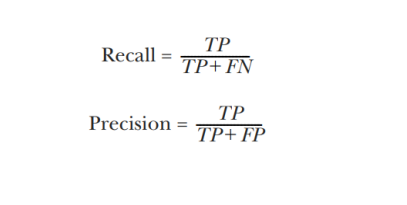

Recall : 실제 찾아내야 될 놈을 얼마나 찾아냈느냐

빨간불인 경우 Recall이 높아야함

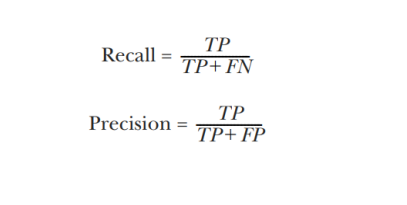

Precision : 내가 찾아낸 놈 중에 얼마나 정확하게 찾아냈느냐

파란불인 경우 Precision이 높아야함

TP: 걸렸다고 예측 했는데 실제로 걸린 거 (내가 positive라고 예측했는데 positive가 true인 것)

FN: 안걸렸다고 예측 했는데 실제로 걸린 거(내가 negative라고 예측했는데 negative가 false인 것 - negative가 틀렸으니까 실제는 positive)

TP+FN : 실제로 걸린 것

Recall: 실제로 걸린 것 중에 걸렸다고 예측한 것

=> 빨간불인 경우, 빨간불을 예측하지 못하면 멈추지 않기 때문에 큰 사고가 일어날 수 있다.

빨간불 중에 빨간불을 잘 예측하는 것이 중요하다.

FP: 걸렸다고 예측했는데 실제로 안걸린 거 (내가 positive라고 예측했는데 positive가 false인 것)

TP+FP: 걸렸다고 예측한 것

Precision: 걸렸다고 예측한 것중에 실제로 걸린 것

=> 초록불인 경우, 초록불을 예측하지 못하면 빨간불로 예측해서 멈추지만, 사고는 일어나지 않는다.

따라서 초록불이라고 예측한 것중에서 실제로 초록불인 것이 중요하다.

Recall과 Precision의 조화평균이 F1 Score이다.

두 개의 평가지표를 시각화하는 curve도 있다.

Recall의 경우엔 모두 걸렸다고 하면 1이 나오고, Precision의 경우엔 최대한 초록불이 아니라고 예측하면 높게 나오기 때문에 두 개의 평가지표를 함께 본다.

한 개의 평가지표만 보면 한쪽에 치우쳐져있을 수도 있기 때문이다.

'인공지능' 카테고리의 다른 글

| LG Aimers 선정됐다~! (0) | 2023.12.31 |

|---|---|

| 렐루 함수(ReLU), XAI (0) | 2023.11.23 |

| transformer는 정말 다용도다.. (0) | 2023.11.22 |

| 모델 성능을 높이는 것은 넘 어렵다 (0) | 2023.10.29 |

| 읽고 싶은 논문 리스트 (0) | 2023.09.24 |